如何通过一篇文章的 URL 抓取标题和内容

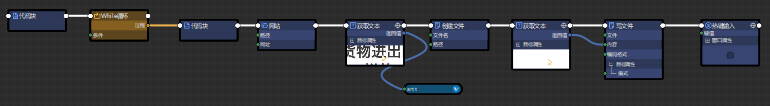

先上流程图:

需求

100 篇网页中的文章,挨个抓出内容存成文本,并以标题命名。

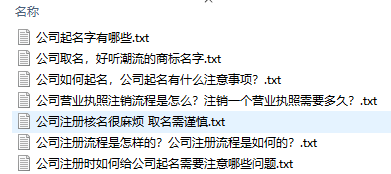

效果是:

分析实现

文章的 URL 已经有了,如下图:

怎么抓取地址的看这个: 用 ISRPA 实现:爬取网页文章到自己的网站中

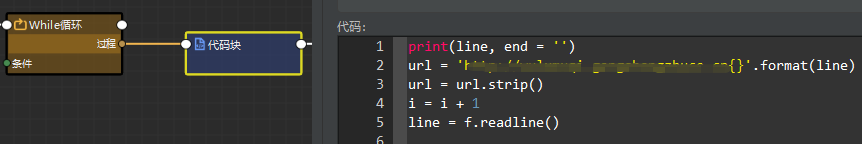

1.1 循环拼接真实地址;

代码块打开文件,一行行读。这里用“打开文件”组件好像不行。

套上循环,拼接域名 + 地址,url。

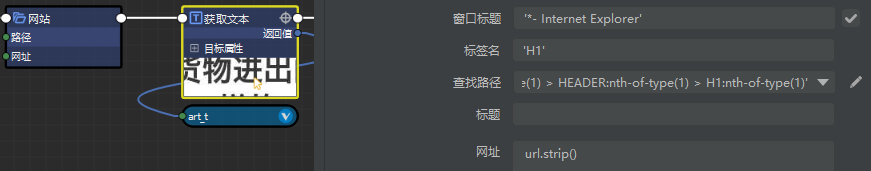

1.2 打开页面,获取标题

地址有了,就可以打开网页,并获取标题了 art_t。

查找路径这里,找一个一定能选到标题的路径。

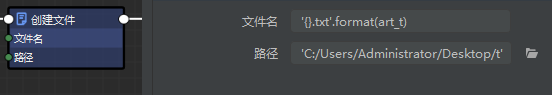

1.3 创建文件,并以标题命名

以文章的标题命名文件名:'{}.txt'.format(art_t),

这里要补充说明一下:某些“特殊字符”是不能用做文件名的。可以用 rs.sub 正则过滤掉。

1.4 获取内容,写入文本,关闭文件

通过“获取文本”,也能获得一段或几段文本的内容,还能自动去掉页面格式,保留 \t\n 等转义字符。

查找路径,要定位到包含文章的所有文本的标签。

你开心就好 😄

TDK 还是要人工优化的。收录的问题用采集解决,排名的问题由第三方解决。 不采集,纯靠手工的也不现实啊。 官网里,也要采集你发的文章,就当提前给你打招呼了啊。哈哈。

采集站 没有 前途啊

兄嘚

这个办法也是挺好的。 不过我爬来的文章是要手工分类的。例如:文章库共 8 个子类,每个子类要求 2000 篇。工程量不大,每天爬上 1000 篇够了,这比人工快的多,满足了。

抓取网址,给你一个小窍门,不需要你写脚本去抓取

很多网站为了更好的被搜索引擎抓取到网页的内容,

会把网站上面的所有 URL 放在一个页面上

这个页面的地址为:www.xx.com/sitemap.txt 或者 www.xx.com/sitemap.html 又或者 www.xx.com/sitemap.xml

你可以去 RPA 某 BOT 网站试试

有现成的何必自己再去爬去