分词, 排序毛毛雨

额, 咋说呢…直接看吧, 就是把一段文章的重点挑出来

# 导入第三方模块

import jieba # 用于中文句子的切词

import collections # 用于词频的排序

# 读入文本

getted_text = open('C:\\Users\\lenovo\\Desktop\\a.txt', encoding='gbk')

read_text = getted_text .readlines()

# 将文本各段内容拼接为一个整体

whole_text = ''.join(read_text)

# 删除特殊字符,如“\n”

whole_text = whole_text.replace('\n', '')

# 对文本内容切词,并保留1个长度以上的词

words_list = []

for i in jieba.lcut(whole_text):

# 通过逻辑判断,保留至少包含两个字符的词

if len(i) > 1:

words_list.append(i)

# 词频统计,并将词频结果存储到字典中

cipin = {}

for i in set(words_list):

cipin[i] = words_list.count(i)

# 对词频结果做排序

print(collections.Counter(cipin).most_common())

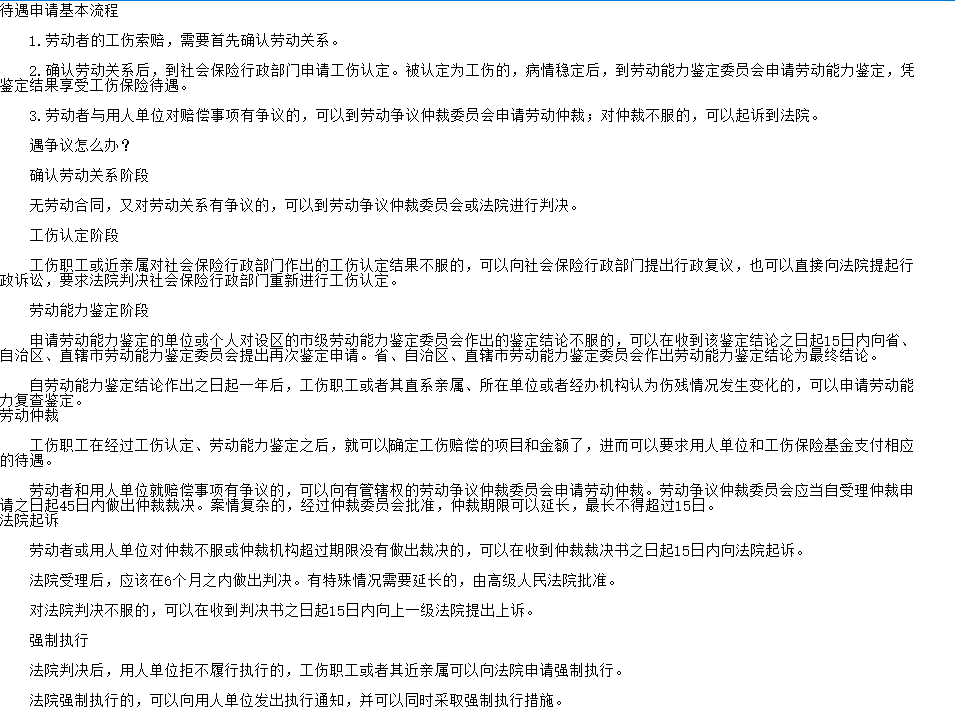

文本如图

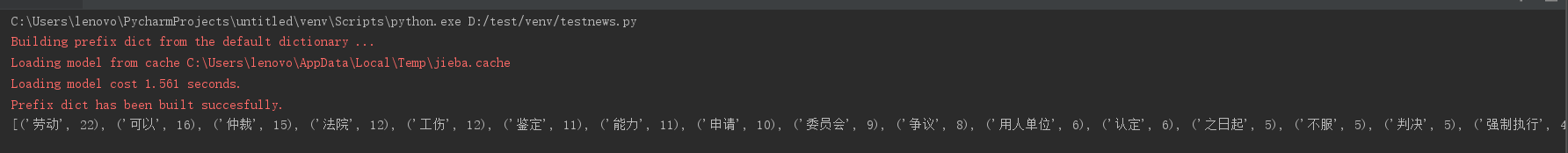

结果如图

那很明显这个文本内容就是和劳动仲裁相关的, 可能一段文本看不出来啥, 但是数量多起来的情况下, 你想直到核心就可以直接很简便的获得了, 并且用得好的情况还能分析出更多的东西哦 😊

嗯,厉害啊

不错哦, 小伙子!

就比如哪吒这个电影在社会的反响到底怎么样, 你可以先所有评论爬下来, 然后用分词, 限定对应的情绪类别, 就可知道正面多还是负面多, 那个词出现的最多, 再比如网上很多那种很多不同大小的词的图片, 就是根据这个词的频率, 重要性来对应大小的 😊

哈哈哈哈哈 collections 这个库,我还研究过。

分词的应用场景是什么啊?能不能分享一下

学到了学到了,多谢分享

黄老师牛掰