Hadoop - 7.Hive 安装(每个节点上都要安装 Hive)

8、Hive 安装(每个节点上都要安装 Hive)

Hive 安装(每个节点上都要安装 Hive)

由于是伪分布式所以这里选用MySQL最为元数据库,将 msyql 和 hive 安装在 master 服务器上,统一给放到 **/usr/local/hadoop**

1、下载安装文件,并解压:

**cd /usr/local/hadoop **# 记得放在 要求的用户下面

wget https://mirrors.cnnic.cn/apache/hive/hive-2.3.4/apache-hive-2.3.4-bin.tar.gz

tar -zxvf apache-hive-2.3.4-bin.tar.gz

如果本地有文件(可以通过 ftp 传)就直接:

tar -zxvf apache-hive-2.3.3-bin.tar.gz(我这里传的是 2.3.3,网上下的最新的是 2.3.4)

如果传的文件不在 ** /usr/local/hadoo下面,可以 :**

sudo cp apache-hive-2.3.3-bin.tar.gz /usr/local/hadoop/apache-hive-2.3.4-bin.tar.gz

然后在解压

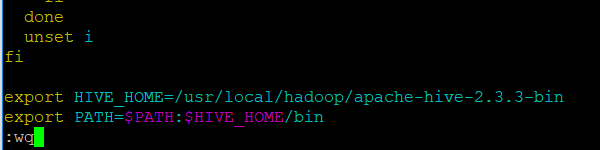

2、配置环境变量

现在在 ** /usr/local/hadoop ** 安装目录下。

sudo vim /etc/profile

export HIVE_HOME=/usr/local/hadoop/apache-hive-2.3.3-bin

export PATH=$PATH:$HIVE_HOME/bin

**source /etc/profile **# 使文档生效 ~!几乎每次修改文档都要有哦。

chown –R hadoop:hadoop /usr/local/hadoop